Интернет магазин китайских планшетных компьютеров |

|

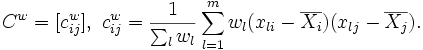

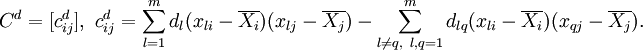

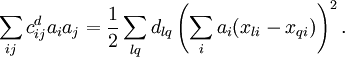

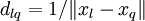

Компьютеры - Метод главных компонент - Механическая аналогия и метод главных компонент для взвешенных данных22 января 2011Оглавление: 1. Метод главных компонент 2. Формальная постановка задачи 3. Диагонализация ковариационной матрицы 4. Сингулярное разложение матрицы данных 5. Матрица преобразования к главным компонентам 6. Отбор главных компонент по правилу Кайзера 7. Оценка числа главных компонент по правилу сломанной трости 8. Нормировка 9. Механическая аналогия и метод главных компонент для взвешенных данных 10. Специальная терминология 11. Примеры использования Если сопоставить каждому вектору данных единичную массу, то эмпирическая ковариационная матрица C совпадёт с тензором инерции этой системы точечных масс, а задача о главных компонентых — с задачей приведения тензора инерции к главным осям. Можно использовать дополнительную свободу в выборе значений масс для учета важности точек данных или надежности их значений. Если вектору данных xl придаётся масса wl, то вместо эмпирической ковариационной матрицы C получим Все дальнейшие операции по приведению к главным компонентам производятся так же, как и в основной версии метода: ищем ортонормированный собственный базис C, упорядочиваем его по убыванию собственных значений, оцениваем средневзвешенную ошибку аппроксимации данных первыми k компонентами, нормируем и т. п. Более общий способ взвешивания даёт максимизация взвешенной суммы попарных расстояний между проекциями. Для каждых двух точек данных, При dlq > 0 симметричная матрица C положительно определена, поскольку положительна квадратичная форма: Далее ищем ортонормированный собственный базис C, упорядочиваем его по убыванию собственных значений, оцениваем средневзвешенную ошибку аппроксимации данных первыми k компонентами и т. д. — в точности так же, как и в основном алгоритме. Этот способ применяется при наличии классов: для Другое применение — снижение влияния больших уклонений, которые могут искажать картину из-за использования среднеквадратичного расстояния: если выбрать Просмотров: 23157

|

вводится вес dlq; dlq = dql и

вводится вес dlq; dlq = dql и  . Вместо эмпирической ковариационной матрицы C используется

. Вместо эмпирической ковариационной матрицы C используется

, то влияние больших уклонений будет уменьшено. Таким образом, описанная модификация метода главных компонент является более робастной, чем классическая.

, то влияние больших уклонений будет уменьшено. Таким образом, описанная модификация метода главных компонент является более робастной, чем классическая.